Übersicht KI- und ML-Stacks, Teil 1 KI-Engines im Bündel mit Hardware

Künstliche Intelligenz (KI) „fällt nicht vom Himmel“. Leistungsstarke KI-Lösungen entstehen auf der Basis gut abgestimmter KI- und Machine Learning Stacks. Davon gibt es zum Glück einige. Etablierte Softwareentwicklungshäuser sind in Sachen KI und Machine Learning (ML) mittlerweile fest im Sattel. Inzwischen wollen andere Unternehmen auch mit ins Boot.

Anbieter zum Thema

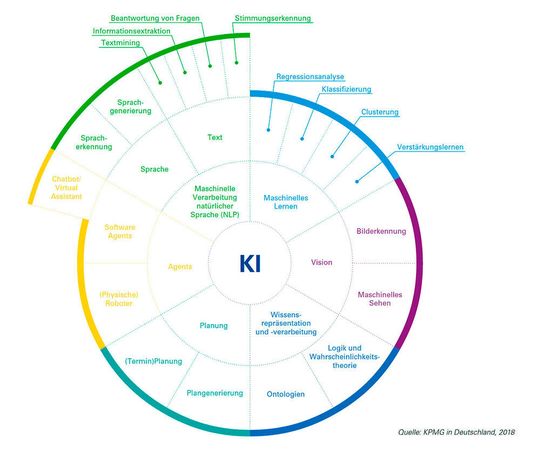

Künstliche Intelligenz gilt als ein Oberbegriff für lernfähige Systeme und deckt Maschinelles Lernen (ML) eigentlich mit ab. Der Begriff KI findet dann Anwendung, wann immer von lernenden Anwendungen die Rede ist – auch Algorithmen des Deep Learnings sind hiermit abgedeckt. Im Gegensatz dazu stellt ML die autarken oder semi-autarken Handlungsfähigkeiten cyberphysischer Systeme in den Vordergrund, welche hierzu die Analyse von Datenströmen aus Sensorik in nahezu Echtzeit meistern müssen.

Begrifflichkeiten jetzt aber beiseite: Der KI/ML-Goldrausch ist in vollem Gange. IDC-Analysten zufolge soll der weltweite Markt für KI/ML-Lösungen im laufenden Jahr satte 35,8 Milliarden US-Dollar erreichen und sich damit gegenüber dem Vorjahr mit 44 Prozent Wachstum nahezu verdoppeln.

Das deutsche Bruttoinlandsprodukt (BIP) könnte sich dank KI bis zum Jahr 2030 um insgesamt 11,3 Prozent vergrößern, schätzt PwC. Dieses Wachstum entspricht einer Wertschöpfung von rund 430 Milliarden Euro, also knapp über der aktuellen Gesamtwirtschaftsleistung von Ländern wie Österreich und Norwegen.

Sehen, Hören, Handeln

Unternehmen erhoffen sich von KI/ML-Algorithmen zur Auswertung von Big Data einzigartige Wettbewerbsvorteile: mehr Customer Intelligence, niedrigere Kosten dank prädiktiver Instandhaltung, geringere Betriebsrisiken durch Betrugsprävention und Früherkennung von Cyberangriffen. Den Anwendungsmöglichkeiten sind praktisch keine Grenzen gesetzt, sofern sich das Vorhandensein hochwertiger Datenquellen gewährleisten lässt.

Doch was nützt KI als ein Alleinstellungsmerkmal, wenn alle Akteure über dieselben Algorithmen verfügen? Nicht viel. Erst fortgeschrittene KI-Stacks schaffen die Grundlagen, um den Lernfähigkeiten der eigenen Anwendungen die so begehrte Exklusivität zuteilwerden zu lassen.

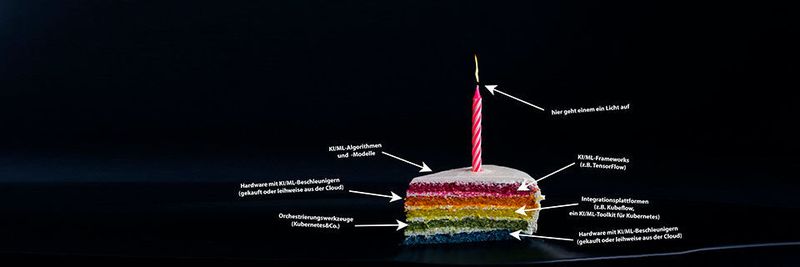

Ein KI-Stack setzt sich wie eine traditionelle Schichttorte aus mehreren Ebenen zusammen. Idealerweise sollten diese ineinander „greifen“ und beim Schneiden und Servieren (sprich: beim Orchestrieren) gut zusammenhalten. Die unterste Ebene des Stacks bildet eine KI/ML-optimierte Hardware (siehe den Abschnitt „Aufgebohrt: KI-Optimierte Hardware“ weiter unten). Auf diesem Infrastrukturfundament setzen dann die Orchestrierungswerkzeuge auf (z. B. Kubernetes). Eine weitere Softwareschicht, die dann wiederum darauf aufbaut, zeichnet für das Management der Orchestrierungswerkzeuge und somit auch die Portabilität des Softwarestacks zwischen verschiedenen Laufzeitumgebungen verantwortlich (mehr zu diesen Aspekten eines Stacks im Abschnitt „Eingespielt: Orchestrierungs-Tools für KI/ML-Workloads“ im zweiten Teil dieser Folge).

Darauf setzt dann das eigentliche KI/ML-Framework auf. Dieses lässt sich gegebenenfalls um externe Dienste, Bibliotheken und sonstige anwendungsspezifische Erweiterungen ergänzen (z. B. im Bereich der Bilderkennung oder Sprachanalyse). Erst oberhalb dieser Schicht entstehen die eigentlichen KI/ML-Modelle und -Visualisierungen. Aus welchen Bestandteilen sich ein bestimmter KI/ML-Stack im Einzelnen zusammensetzt, hängt also im Endeffekt von den avisierten Anwendungsszenarien ab.

Aufgebohrt: KI-optimierte Hardware

KI-Algorithmen wie künstliche Neuronale Netze für maschinelles Lernen müssen in der Inferenzphase die anfallenden Datenströme möglichst echtzeitnah verarbeiten, um zu gewährleisten, dass cyberphysische Systeme auch in Situationen mit hoher Ungewissheit und in einem stark individualisierten Kontext autark handeln können. Neuronale Netze durchlaufen üblicherweise die hierzu erforderliche Trainingsphase, welche die Verarbeitung massiver Big-Data-Bestände voraussetzt, in verteilten Anwendungsarchitekturen in einem voll ausgewachsenen Rechenzentrum. Erst die Inferenzphase kann dann auf dem betreffenden cyberphysischen Edge-System stattfinden (zum Beispiel in einer autonomen Drohne).

Im Gegensatz dazu können sich diejenigen lernenden Algorithmen, die rein historische Daten verarbeiten, sich zwar damit generell mehr Zeit lassen, doch für die Entwickler gestaltet sich das Ganze wohl kaum einfacher. Denn in der ursprünglichen Lernphase geht es vorrangig darum, zuvor ungekannte Zusammenhänge in massiven Datenmengen aufzudecken, statt „nur“ vorgegebenen Denkmustern durch iterative Verbesserungen zu folgen. Diese Herangehensweise ist unter dem Namen Deep Learning bekannt.

Konventionelle CPUs sind mit datenlastigen KI-Workloads nach wie vor überfordert. Sie haben ja auch mittlerweile kaum Spielraum, an Leistung zuzulegen, weil sich das Mooresche Gesetz unweigerlich seinem Ende nähert. Der Aufbau eines KI/ML-Stacks setzt daher zwingend geeignete Hardware voraus. Es fragt sich nur, welche.

Eingebettet: den Datenhunger sättigen

Bisher stehen Entwicklern von KI/ML-Algorithmen GPUs (Graphic Processing Units) von NVIDIA, FPGAs (Field Programmable Gate Arrays) und ASICs wie die TPU (Tensor Processing Units) von Google zur Verfügung.

Diese und andere KI/ML-optimierte Chip-Architekturen sollen über das Ende des Mooreschen Gesetzes hinaus eine Brücke in die Zukunft schlagen. Welches Gelände sich den KI/ML-Entwicklern auf dem anderen Ende dieser Brücke erschließt, weiß bisher so genau noch keiner. Laut den Analysten von Gartner dürften u. a. Quanten-Computer und neuromorphische Chips die Nachfolge heutiger Hardwarebeschleuniger und domainspezifischer Prozessoren antreten.

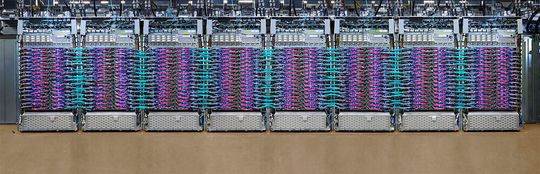

Zu den guten Nachrichten zählt der Umstand, dass Unternehmen KI-Stacks aufbauen können, ohne sich erst mit spezialisierter Hardware eindecken zu müssen. Die führenden Cloud-Dienstleister bieten Hardware als ein Service aus der Wolke an. So vermietet beispielsweise Google die zweite und dritte Generation der TPU-Beschleuniger für KI-Modelle auf der Basis von Matrizenberechnungen, gebündelt zu je tausend Stück, über die Google Cloud Platform. Als Vorzeigekunden nennt Google u. a. die Metro-Gruppe und die Siemens AG.

Der internationale Spezialist für den Großhandel- und Lebensmitteldirektvertrieb aus Düsseldorf hat seine 100 separaten Buchhaltungssysteme auf SAP-HANA in der Google-Cloud konsolidiert, enthüllt Timo Salzsieder, CIO/CSO der Unternehmensgruppe, bekannt. So könne der Metro-Konzern fortgeschrittene Big-Data-Analysetechniken und KI u. a. zur Optimierung der eigenen Versorgungsketten nutzen.

Der Lebensmittelkonzern lässt seine Daten in die serverlose PaaS-Plattform BigQuery von Google via die Datalab-Infrastruktur einfließen. Hier entstehen unter Verwendung des quelloffenen KI-Frameworks TensorFlow und unter aktiver Mitwirkung der KI-Spezialistin Freiheit.com Technologies GmbH aus Hamburg die eigentlichen ML-Modelle, enthüllt Stefan Richter, Founder and Head of Engineering bei freiheit.com. Die so gewonnenen Erkenntnisse ließen sich dann mithilfe von Google Data Studio in verschiedenen Unternehmensbereichen visualisieren. So lernt die Metro-Gruppe ihre Kunden in Echtzeit kennen.

Branchenspezifische Full-Stack-Fertiggerichte servieren — oder lieber doch selbst backen?

Im Grunde genommen stehen den Unternehmen in Bezug auf die Wahl eines KI-Stacks mehrere diametral unterschiedliche Ansätze offen. Zum einen gibt es branchenspezifische Full-Stack-Umgebungen wie die Drive-Plattform für autonome Fahrzeuge von NVIDIA. Das Unternehmen bietet seinen Partnern unter anderem Referenzdesigns, eine Entwicklungsumgebung, eine Simulationsplattform und ein künstliches neuronales Netzwerk zum Trainieren von ML-Fähigkeiten im Bereich der audiovisuellen Wahrnehmung. NVIDIA ging bereits strategische Partnerschaften unter anderem mit Audi, Mercedes-Benz und VW ein.

Wer eine solche branchenspezifische KI-Entwicklungsplattform nicht benötigt, kann einen eigenen KI/ML-Stack aus quelloffenen Frameworks wahlweise auf eigener Hardware und/oder — wie die Metro-Gruppe — in der Cloud zusammenstellen (siehe dazu den zweiten Teil des Berichtes „KI/ML-Stacks, Teil 2: die (künstliche) Framework-Intelligenz“).

Viele der beliebtesten quelloffenen Frameworks für Maschinelles Lernen (ML), allen voran TensorFlow, sind bei den großen Cloud-Anbietern als vollständig „gemanagte“ Services verfügbar. Dies senkt die Verwaltungskosten, fördert jedoch die Abhängigkeit von den proprietären Lösungen und den Kompetenzen des jeweiligen Dienstleisters.

Cloud-Dienste trumpfen wiederum mit der Fähigkeit, ihren Nutzern die benötigten Hardwarebeschleuniger bedarfsgerecht und kostengünstig zur Verfügung zu stellen. Amazons KI-Dienst Elastic Inference unterstützt beispielsweise den Einsatz von GPU-Beschleunigern für KI/ML-Workloads des Deep Learnings in der Cloud.

McKinsey Global Institute (MGI) schätzt das Wachstumspotenzial der deutschen Wirtschaft durch KI-Technologien bis zum Jahre 2030 (jährlich 1,3 Prozent) auf etwa 16,7 Prozent. Um dieses Ziel zu erreichen, müssten allerdings 70 Prozent aller Unternehmen bis zum Jahr 2030 KI-Lösungen einsetzen, vor allem in den Bereichen automatische Bilderkennung, natürliche Sprache, virtuelle Assistenten, roboterbasierte Prozessautomatisierung und fortgeschrittenes maschinelles Lernen.

Fazit

Die Wahl des KI/ML-Stacks ist keine leichte Entscheidung. Um die steile Lernkurve zu überwinden, entscheiden sich einige Firmen für strategische Partnerschaften, andere wählen wiederum den Weg der kleine Schritte, indem sie eine KI/ML-Lösung nach einem eigenen Rezept aus öffentlich verfügbaren KI/ML-Frameworks „backen“ und hierbei auf die Kompetenzen von Infrastrukturdienstleistern und KI/ML-Entwicklungsschmieden zurückgreifen. Wie dem auch sei: An der intelligenten Auswertung von Big Data kommt keiner mehr vorbei.

:quality(80)/images.vogel.de/vogelonline/bdb/1614600/1614665/original.jpg)

Übersicht KI- und ML-Stacks, Teil 2

Künstliche Intelligenz im Eigenbau

(ID:46119526)

:quality(80)/p7i.vogel.de/wcms/0a/ad/0aad4d1cac89c39a3d2a2bd715064a4d/0129639119v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/05/87/0587f06864248d5bc9203a6ae3425e81/0129135308v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/6b/cd/6bcdbf73384eed09f52f7a32a0b8394d/0129219515v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/07/2d/072d563f8e06f65e2a31d9bedd427fac/0129034362v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/09/d2/09d279a504af5f2d43d66ceac11523d5/0129626850v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/69/77/6977dceebf7e9d4af0f69fc975ec7890/0129070771v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/44/17/4417973fa69edeb509aebb9aba0579b7/0128919402v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e7/34/e734f4d362cad6fc347f5a049b1522db/0129238699v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/eb/93/eb93a51ff7c427f71171f547d011bfb8/0127827710v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/73/f8/73f823d4efa52d189464ba7f14e67353/0128362051v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d4/90/d49096fad857f07b788198c34b35e010/0128339234v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e1/53/e1539f6251b6e5502bd1856048c4267e/0128161589v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c9/1a/c91ad9dfc806cc7df9fe7074ca5e64dd/0127064676v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/43/e4/43e42f37cc71f12e6ae46717e700644e/0126701619v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/39/09/390978331ebdf2bcf9510be67adae57d/0126741038v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d2/81/d281ca9ba4dc5a51fbadbde073a08c7e/0129432464v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/58/df/58df8fb80642acb12018283c32bc55ad/0129070800v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/8d/62/8d62d570c33157ea78ff9697c0f8e141/0129062190v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/41/aa/41aa0e5b61dfb015100a7372018ce585/0128444593v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/6f/796f33fbca1e803a117f8b35c3452463/0129343775v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/9b/c3/9bc3650365043192ef4509df28ac6859/0129429761v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d5/b1/d5b1475f88870d67e1b4c6a4ad41863c/0129446723v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/20/cd/20cdab2c04c467fc42fe2ffee2c14e1c/0129407259v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/16/ab/16ab7543ab1c19a83e1a6cad31f787dd/0116453263v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/2c/25/2c25cde2a511a2b845f0886a298a52d1/0129542705v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c6/a6/c6a6747ffbc7b230d6443212c6082c92/0129641270v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/68/f8/68f8b9869e1288dfa2eeff3a1dc6a7eb/0127838110v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/74/05/74053661b14a2f12ec5e98ebd1469197/0127788138v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/0f/36/0f36632bd2160924da97db0211b6e1c0/0127421038v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/eb/bc/ebbcbb417d292f3d20cb3bf87706705c/0125514392v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/82/9a/829ab32db929fbae572a7c8290463a08/0121295821v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/48/29/4829b98ab651ba9160c517c0e1388ee2/0121130893v3.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/68/2d/682dd583dcc4c/fsas-afc-horizontal-2-positive-rgb-nov24.png)

:fill(fff,0)/p7i.vogel.de/companies/64/59/6459ff78aba1f/infomotion-logo-bild-text-rgb.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/5e/b4/5eb41ddf8e0b6/bdi-insider-logo-2019.png)

:quality(80)/p7i.vogel.de/wcms/88/71/887169bca143bd080356b5395686cf81/0125685819v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/21/83/2183b1d12ff249dbe99b3b2057c4ad39/0127126428v2.jpeg)