Grundlagen Statistik & Algorithmen, Teil 4 Der Monte-Carlo-Algorithmus und -Simulationen

Eine Reihe von Algorithmen dient der Suche von Lösungen, ohne vorher die Antwort zu kennen, und von Entscheidungen, die nach „wahrscheinlich richtig oder falsch“ beurteilt werden. Das ist sinnvoll für das Risiko-Management, aber auch für die Nutzung von Supercomputern. Ein solcher Algorithmus ist der Monte-Carlo-Algorithmus und die darauf basierenden Simulationen

Anbieter zum Thema

Im Unterschied zu einem deterministischen Algorithmus, der mit definierten und reproduzierbaren Zuständen arbeitet, arbeitet ein Monte-Carlo-Algorithmus ergebnisoffen mit Zufallswerten. Das klingt zunächst zwar wenig ermutigend, aber der Nutzer arbeitet hier, wie sonst, mit Wahrscheinlichkeiten statt mit Gewissheiten.

Ein Monte-Carlo-(MC)-Algorithmus ist ein randomisierter Algorithmus, der durch die Wahl von zufälligen Zwischenergebnissen zu einem (im Mittel) guten bzw. näherungsweise korrekten Ergebnis gelangen soll. Mit Zufallswerten gefüttert, darf der MC-Algorithmus mit einer nach oben beschränkten Wahrscheinlichkeit ein falsches Ergebnis liefern. Man rechnet also keinesfalls wild drauflos, bis der Welt die Energie ausgegangen ist, sondern hat von vornherein eine Bremse eingebaut.

Wiederholt man den Algorithmus mit unabhängigen Zufallsbits genügend oft, wird sukzessive die Fehlerwahrscheinlichkeit gesenkt. Sinkt sie unter einen vertretbaren Schwellenwert (KPI: Key Performance Indicator), dann ist die Antwort bzw. Entscheidung wahrscheinlich richtig. Der Clou: Der MC-Algorithmus darf ein falsches Ergebnis liefern, sein ebenso randomisierter Bruder, der Las-Vegas-Algorithmus, darf hingegen nur korrekte Lösungen berechnen. Beide lassen sich ineinander konvertieren.

Entscheidungsprobleme

Wie gesagt, gibt es Monte-Carlo-Algorithmen für Suchprobleme (Probleme, bei denen eine Lösung zu berechnen ist) und für Entscheidungsprobleme (Probleme, bei denen eine Ja/Nein-Frage zu beantworten ist). Eine solche Entscheidung könnte die Beurteilung eines eingehenden Datenpakets nach seiner Legitimität und Unschädlichkeit sein, aber auch ein so komplexer Vorgang wie etwa eine Kreditvergabe (im Bereich Risk Management).

Bei Monte-Carlo-Algorithmen für Entscheidungsprobleme unterscheidet man zwischen ein- und zweiseitigen Fehlern. Bei einem zweiseitigen Fehler darf ein Monte-Carlo-Algorithmus sowohl False Positives liefern (also die Ausgabe „Ja“, obwohl „Nein“ richtig wäre), als auch False Negatives (also die Ausgabe „Nein“, obwohl „Ja“ richtig wäre).

Bei einseitigem Fehler ist nur eine der beiden Fehlermöglichkeiten erlaubt. Eine häufige Vereinbarung besteht darin, von einem einseitigen Fehler zu sprechen und damit False Negatives zu meinen. Es gibt dabei drei Komplexitätsklassen für Probleme.

Komplexitätsklassen für Entscheidungsprobleme mit randomisierten Algorithmen

- BPP (von englisch bounded error probabilistic polynomial time): Wenn die korrekte Ausgabe Ja (Nein) lautet, beträgt die Wahrscheinlichkeit, dass der Algorithmus Ja (oder Nein) ausgibt, mindestens 2/3.

- RP (von englisch randomized polynomial time): Wenn die korrekte Ausgabe Ja lautet, beträgt die Wahrscheinlichkeit, dass der Algorithmus Ja ausgibt, mindestens 1/2. Wenn die korrekte Ausgabe Nein lautet, beträgt die Wahrscheinlichkeit, dass der Algorithmus Nein ausgibt, 1.

- co-RP: Wenn die korrekte Ausgabe Ja lautet, beträgt die Wahrscheinlichkeit, dass der Algorithmus Ja ausgibt, 1; wenn die korrekte Ausgabe Nein lautet, beträgt die Wahrscheinlichkeit, dass der Algorithmus Nein ausgibt, mindestens 1/2. Damit enthält co-RP die Komplemente der Probleme in RP. RP und co-RP ergänzen einander.

Wenn ein solcher RP-Algorithmus die Ausgabe Ja liefert, wissen wir mit Sicherheit, dass die Ausgabe Ja korrekt ist (da die Definition sicherstellt, dass bei korrekter Ausgabe Nein dies auf jeden Fall auch ausgegeben wird). Wenn dagegen ein RP-Algorithmus die Ausgabe Nein liefert, wissen wir nichts über die korrekte Ausgabe (da nach der Definition die Ausgabe Nein möglich ist, wenn Ja oder Nein korrekt wäre).

Anwendungsfälle

Der Nutzwert des MC-Algorithmus wird deutlicher, wenn man seine Anwendungsfälle unter die Lupe nimmt. Ein Beispiel ist der Miller-Rabin-Test, bei dem bestimmt wird, ob eine natürliche Zahl eine Primzahl ist. Die Ausgabe des Tests lautet entweder „sicher zusammengesetzt“ oder „wahrscheinlich prim“. Die Wahrscheinlichkeit, dass eine zusammengesetzte Zahl als „wahrscheinlich prim“ klassifiziert wird, liegt pro Durchgang unter 25 Prozent und kann durch mehrfache Ausführung weiter gesenkt werden (sodass mit höherer Wahrscheinlichkeit Primzahlen gefunden werden). Der Miller-Rabin-Test liefert keine Aussage über die Faktoren einer zusammengesetzten Zahl.

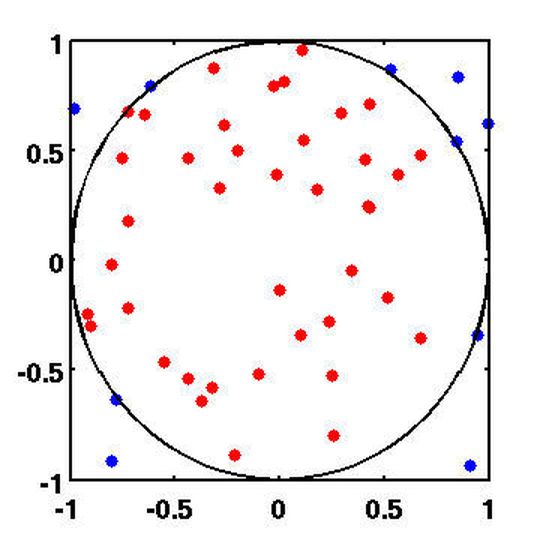

Der Monte-Carlo-Algorithmus lässt sich zur Bestimmung der Kreiszahl Pi heranziehen. Dazu sind die Wahl zufälliger Punkte auf der Kreisfläche und eine sehr komplexe Formel notwendig (siehe Abb. 1). Sie ergibt das Flächenintegral einer Viertelkreisfläche. Aus diesem ergibt sich das Verhältnis von Fläche, Durchmesser und Umfang.

Im Einsatzbereich des Hochleistungsrechnens, das auf massivem Multiprocessing in Parallelverarbeitung über tausende von Prozessorkernen und Rechnerknoten hinweg beruht, lassen sich probabilistische Lösungsverfahren wie der MC-Algorithmus ausnutzen. Zahlreiche Supercomputer in der Top-500-Liste arbeiten deshalb mit Grafikprozessoren (GPU), die für die Parallelverarbeitung optimiert sind.

Monte-Carlo-Simulation

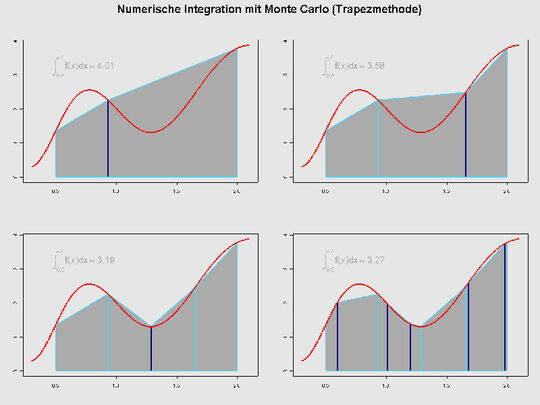

Eine Monte-Carlo-Simulation oder Monte-Carlo-Studie, auch MC-Simulation genannt, ist ein Verfahren aus der Stochastik, bei dem eine sehr große Zahl gleichartiger Zufallsexperimente die Basis darstellt. Auch hier soll die Wahrscheinlichkeitstheorie helfen, aufwendig lösbare Probleme zu beantworten, am denen sich Analyse-Methoden die Zähne ausbeißen würden.

Als Grundlage ist vor allem das Gesetz der großen Zahlen zu sehen. Die Zufallsexperimente können entweder – etwa durch Würfeln – real durchgeführt werden oder in Computerberechnungen. Zur Simulation des Zufalls werden scheinbar zufällig gewählte Zahlen herangezogen und mittels geeigneter Algorithmen wie etwa dem MC-Algorithmus berechnet.

Zu den Anwendungen der MC-Simulation gehören das oben angeführte Beispiel der Bestimmung der Zahl Pi. Die Ermittlung von Verteilungen ist ein eminent wichtiger Bereich in der modernen Wirtschaft, beispielsweise in Werbung, Logistik oder Finanzen. Es lassen sich durch Simulation Zufallsvariablen und Korrelationskoeffizienten ermitteln, die in ihrer Gesamtheit Eingang in eine empirische Verteilungsfunktion finden. Mit dieser Funktion hat man ein alternatives Mittel an der Hand, um Schätzungen für Erwartungswerte vornehmen zu können. Man ist nicht mehr auf das arithmetische Mittel angewiesen und kann zudem die Parameter, die eine Verteilung beeinflussen, schätzen.

Nachbildung komplexer Prozesse

Diese Simulationen helfen bei der Nachbildung komplexer Prozesse wie etwa im Wetter oder im Klima, die sich nicht direkt analysieren lassen. Auch Produktionsprozesse in einem Fertigungsunternehmen sind simulierbar, um Engpässe und Opportunitäten in der Produktion aufzudecken. In der Immobilienwirtschaft lassen sich zwecks Wertermittlung eines Objekts Ableitungen aus bisherigen Bewertungen vornehmen.

Auch an der Börse spielen Simulationen eine zunehmende Rolle, denn dort nimmt die Rechenkapazität ebenso zu wie die Übertragungsgeschwindigkeit der Netzwerke. Wenn beispielsweise keine analytische Formel für die Bewertung eines Finanzproduktes bekannt ist, lassen sich durch MC-Simulation geeignete Verteilungsannahmen der relevanten Zufallsgrößen finden und auf einfache Art komplexe Finanzkontrakte bepreisen. Das ist ungefähr so, als würde man ein Karnickel aus einem Hut zaubern, in den man zuvor nur etwas Feenstaub (die MC-Simulation) gestreut hat.

In letzter Zeit haben besonders die Physik und das darauf basierende Engineering von den Möglichkeiten der MC-Simulation profitiert. Wohin wird sich beispielsweise ein Regentropfen, der auf die Erde fällt, weiterbewegen? Er wird zufällig mit anderen Tropfen gleicher Größe in gleichartiger Umgebung kollidieren. Wird er dabei zerfallen oder sich mit anderen Tröpfchen vereinigen?

Nach der Simulation mehrerer konkreter Tropfen sind Aussagen über die durchschnittliche Tropfengröße möglich oder auch zu Temperatur und Tröpfchendichte, bei denen Schnee oder Hagel entstehen. Das Phänomen der Tröpfchen ist von großer Bedeutung bei der Konstruktion von Einspritzpumpen in Verbrennungsmotoren. An der Universität Stuttgart ist es dadurch gelungen, den Benzinverbrauch eines Verbrennungsmotors um einen zweistelligen Prozentsatz zu senken. Am Höchstleistungsrechenzentrum Stuttgart (HLRS) wird auch in einer Art Rundum-Kino der Zerfall eines Treibstoff-Tropfens als Simulation gezeigt, natürlich in extremer „Zeitlupe“ – ein faszinierender Anblick.

:quality(80)/images.vogel.de/vogelonline/bdb/1396700/1396763/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 1

Das Problem des Handlungsreisenden und seine praktischen Anwendungen

:quality(80)/images.vogel.de/vogelonline/bdb/1404000/1404092/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 2

So verfeinert das Bayes-Theorem Spam-Filter – und mehr

:quality(80)/images.vogel.de/vogelonline/bdb/1409900/1409917/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 3

Speed für Mustererkennung mit dem Rete-Algorithmus

:quality(80)/images.vogel.de/vogelonline/bdb/1481900/1481934/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 5

Optimale Clusteranalyse und Segmentierung mit dem k-Means-Algorithmus

:quality(80)/images.vogel.de/vogelonline/bdb/1509200/1509209/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 6

Die Ereigniszeitanalyse – wenn Anfang und Ende die Erfolgsrate bestimmen

:quality(80)/images.vogel.de/vogelonline/bdb/1524900/1524972/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 7

So deckt der Local Outlier Factor Anomalien auf

(ID:45415245)

:quality(80)/p7i.vogel.de/wcms/df/b0/dfb069f4822deb450a9e2901086e764a/0129063525v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4c/74/4c74fc8b159433dda8f875c353283eef/0129069237v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/0d/7d/0d7d4d387b2df6692d3d0f729d4680d9/0128775027v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ab/71/ab71eadf052742a3133b1bf01a5b4094/0128381066v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/69/77/6977dceebf7e9d4af0f69fc975ec7890/0129070771v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/44/17/4417973fa69edeb509aebb9aba0579b7/0128919402v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/85/2f/852ff89e3ef46f49350791602e5420ed/0128485353v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/21/00/21000a287989508668d9df02312fb708/0127948285v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/eb/93/eb93a51ff7c427f71171f547d011bfb8/0127827710v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/73/f8/73f823d4efa52d189464ba7f14e67353/0128362051v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d4/90/d49096fad857f07b788198c34b35e010/0128339234v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/95/a9/95a926949a211ff3f81e7e99876c5065/0128215860v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e1/53/e1539f6251b6e5502bd1856048c4267e/0128161589v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c9/1a/c91ad9dfc806cc7df9fe7074ca5e64dd/0127064676v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/43/e4/43e42f37cc71f12e6ae46717e700644e/0126701619v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/39/09/390978331ebdf2bcf9510be67adae57d/0126741038v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/58/df/58df8fb80642acb12018283c32bc55ad/0129070800v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/8d/62/8d62d570c33157ea78ff9697c0f8e141/0129062190v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/41/aa/41aa0e5b61dfb015100a7372018ce585/0128444593v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/a8/de/a8defd2a773ed58c7a375bb9b1765f75/0128366231v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e7/6c/e76c7dca09c6ba87e568703e9226b51d/0128959729v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/78/43/7843aa74049df153fbe3a48504b78e13/0128881472v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ed/03/ed03b3f1a51ed083929721c823be9a72/0128967846v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/4b/b4/4bb4a38dd71121f624a7a465dabcf4cc/0128735549v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/7b/88/7b88c3b2a1abe09513fb25943b91f852/0129106836v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/9f/ba/9fba1120e021f71cd7609844067b8cf8/0129116615v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/68/f8/68f8b9869e1288dfa2eeff3a1dc6a7eb/0127838110v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/74/05/74053661b14a2f12ec5e98ebd1469197/0127788138v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/0f/36/0f36632bd2160924da97db0211b6e1c0/0127421038v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/eb/bc/ebbcbb417d292f3d20cb3bf87706705c/0125514392v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/82/9a/829ab32db929fbae572a7c8290463a08/0121295821v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/48/29/4829b98ab651ba9160c517c0e1388ee2/0121130893v3.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/68/2d/682dd583dcc4c/fsas-afc-horizontal-2-positive-rgb-nov24.png)

:fill(fff,0)/p7i.vogel.de/companies/61/8e/618e774811e12/logo-disy-mit-slogan.png)

:fill(fff,0)/p7i.vogel.de/companies/64/59/6459ff78aba1f/infomotion-logo-bild-text-rgb.jpeg)

:quality(80)/p7i.vogel.de/wcms/00/25/0025c1bc80460116138ea761d1209a60/0123327739v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/b9/b1/b9b16933b71db429c5f0562281ad8299/0124334889v1.jpeg)