Grundlagen Statistik & Algorithmen, Teil 6 Die Ereigniszeitanalyse – wenn Anfang und Ende die Erfolgsrate bestimmen

Die Ereigniszeitanalyse bzw. Survival Analysis umfasst eine Reihe von Werkzeugen der Statistik, mit denen die Zeit bis zum Eintritt eines bestimmten Ereignisses zwischen Gruppen verglichen wird. Auf diese Weise will man die Wirkung von prognostischen Faktoren, einer medizinischen Behandlung oder von schädlichen Einflüssen abschätzen. Bei dem Ereignis kann es sich um etwas so Endgültiges wie den Tod handeln, aber auch um den Verlust einer Arbeitsstelle, eine Scheidung oder einen Beginn, etwa um eine Geburt oder einen Heilungseintritt.

Anbieter zum Thema

Mit dem Sammelbegriff der „Survival- und Ereigniszeitanalyse“ werden eine Reihe von statistischen Verfahren bezeichnet, die der Untersuchung von Zeitintervallen zwischen aufeinander folgenden Ereignissen oder Zustandswechseln dienen. Die von den Untersuchungseinheiten wie etwa Individuen, Haushalten oder Organisationen eingenommenen Zustände sind dabei stets abzählbar.

In der Regel handelt es sich um eine relativ begrenzte Anzahl von Zuständen wie etwa hohe/tiefe Körpertemperatur, hohe/niedrige Feuchtigkeit usw. Die erfassten Ereignisse können zu beliebigen Zeitpunkten eintreten, bezeichnen aber für gewöhnlich einen Anfangs- oder Endpunkt, wie etwa eine Geburt, eine Inbetriebnahme, eine Heilung, eine Erkrankung oder das Lebensende – auch das einer Maschine.

Anwendungsfelder

Weil die Ereigniszeitanalyse in der Soziologie und in den Ingenieursdisziplinen so vielfältig verwendbar ist, lassen sich zahlreiche Beispiele für solche Prozesse finden. So sind etwa die Dauer der Arbeitslosigkeit bis zum Beginn einer neuen Erwerbstätigkeit für die Arbeitsmarktforschung interessant. Die Zeit in einer beruflichen Tätigkeit bis zu einem sozialen Aufstieg ist für die soziale Mobilitätsforschung von Interesse. Die Dauer bis zu einem Umzug an einen anderen Ort ist für die Migrationsforschung relevant. Die Ehedauer bis zur Scheidung taucht in der demografischen Forschung auf und die Überlebenszeiten von Patienten werden in medizinischen Studien erfasst.

Analog dazu lassen sich Maschinen beschreiben, etwa im Smart Grid, in einer komplexen Maschine oder in einem sensorgestützten IoT-System. Deshalb wird das Verfahren im Englischen auch „Reliability Theory“, also Zuverlässigkeitsanalyse, genannt. Üblicherweise werden nur Ereignisse untersucht, die höchstens ein Mal pro Subjekt bzw. Gruppe auftreten können, etwa eine Lebenszeit. Eine Erweiterung auf wiederholt auftretende Ereignisse ist indes möglich.

Statistische Funktionen

Es geht stets darum, zentrale Kenngrößen wie etwa die Überlebensrate einer Gruppe oder die Zuverlässigkeit einer Maschine herauszufinden. Daraus folgt, dass die Überlebensfunktion S analog zur Zuverlässigkeitsfunktion R(t) berechnet wird, wobei der Faktor t Zeit ist und P die Höhe der Wahrscheinlichkeit: S(t) = R(t) = P (T>t). T ist die verbleibende Dauer zum Lebensende eines Organismus oder zum Ausfall eines Geräts. Normalerweise ist S(0) = 1, sonst kann nämlich ein sofortiger „Tod“ oder Geräteausfall eintreten.

Aus der Überlebensfunktion lassen sich verschiedene Größen ableiten. Die Ereigniszeit-Verteilungsfunktion, in technischem Bezug auch als Ausfallswahrscheinlichkeit („Probability of failure“) bezeichnet und mit F abgekürzt, ist die komplementäre Funktion zur Überlebensfunktion: F(t). Die erste Ableitung von F, die Ereignisdichtefunktion oder Ausfallsdichte („failure density function“), wird mit f bezeichnet. Die Ereignisdichtefunktion ist die Rate des betrachteten Ereignisses pro Zeiteinheit.

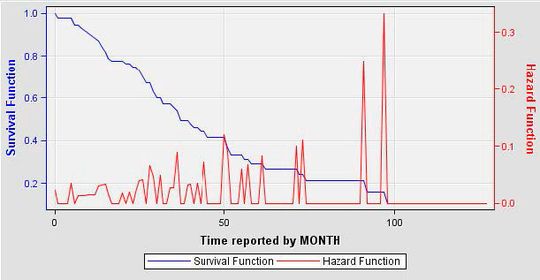

Die Ausfallrate, auch als Hazardfunktion bezeichnet und mit h(t) bezeichnet, ist definiert als Häufigkeit, mit der ein Ereignis zum Zeitpunkt T eintritt, vorausgesetzt, dass es bis zum Zeitpunkt t noch nicht eingetreten ist. Der englische Ausdruck „force of mortality“ (Sterblichkeitsrate) wird speziell in der Demografie verwendet. Die Hazardfunktion kann anwachsen oder fallen, sie braucht weder monoton noch stetig zu sein.

Die verbleibende Lebenszeit zu einem Zeitpunkt t0 ist die bis zum Tod bzw. Ausfall verbleibende Zeit, also T - t0. Die zukünftige Lebenserwartung ist der Erwartungswert der verbleibenden Lebenszeit. Für t0 = 0 reduziert sich dies auf die Lebenserwartung bei der Geburt. In Zuverlässigkeitsanalysen wird die Lebenserwartung englisch „mean time to failure“ (MTTF) und die zukünftige Lebenserwartung englisch „mean residual lifetime“ (MRL) genannt. MTFF ist eine obligatorische Angabe für jede Art von elektrischem oder elektronischem Gerät. Nach Ablauf dieses „Mindesthaltbarkeitsdatums“ sollte das Gerät ausgetauscht werden.

Weitere Methoden

Die statistischen Methoden der Ereigniszeitanalyse reichen von den deskriptiven Verfahren der Survivalanalyse (z. B. Sterbetafel-Methode und Kaplan-Meier-Schätzung), über das semiparametrische Regressionsmodell von Cox, bis zu den parametrischen Verfahren mit und ohne Zeitabhängigkeiten, so etwa dem Exponential-, Piecewise-Constant-, Gompertz (-Makeham)-, Weibull- oder log-logistischen Modell. Im begrenzten Rahmen dieses Beitrag können nur der Kaplan-Meier-Schätzer und das Cox-Modell näher vorgestellt werden.

Kaplan-Meier-Schätzer (KMS)

Der Kaplan-Meier-Schätzer-Algorithmus, bereits 1958 formuliert, ist eine der am häufigsten verwendeten Methoden der „Survival Analysis“ und in praktisch jedem Statistikpaket (SAS, R, Mathematica, Python usw.) zu finden. Der KMS dient zum Schätzen der Wahrscheinlichkeit, dass bei einem Versuchsobjekt ein bestimmtes Ereignis innerhalb eines Zeitintervalls nicht eintritt.

Es handelt sich um eine nichtparametrische Schätzung der Überlebensfunktion (s.o.) im Rahmen der Ereigniszeitanalyse. Der KMS lässt sich beispielsweise nutzen, um die Sterbewahrscheinlichkeit eines Patienten oder die Ausfallwahrscheinlichkeit eines Geräts zu kalkulieren.

Für eine KM-Verlaufskurve sind zwei Daten nötig: der Status der letzten Messung bzw. Beobachtung und die Zeit bis zum Ereignis. Sollen die Überlebensfunktionen zweier Gruppen verglichen werden, wird ein drittes Datum benötigt: die Gruppenzuordnung jeden Subjekts. Auf diese Daten braucht man nur noch die KM-Formel anwenden.

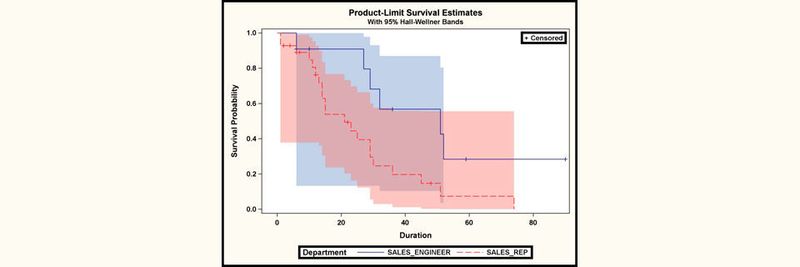

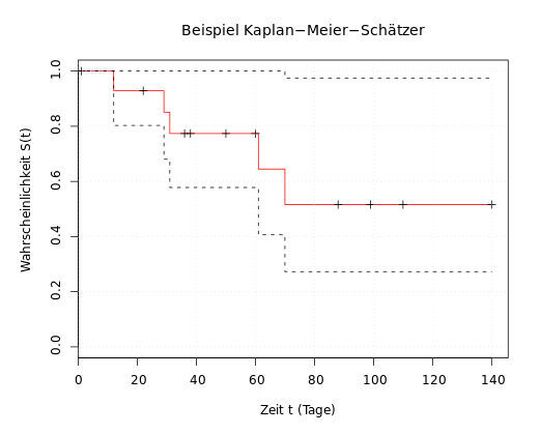

Das Verlaufsdiagramm eines KM-Schätzers (siehe Abbildungen) besteht aus einer Reihe von absteigenden horizontalen Schritten bzw. Stufen, welche, eine ausreichend große Datenmenge vorausgesetzt, sich der wahren Überlebensfunktion (s. o.) dieser Bevölkerungsgruppe annähert. Der Wert der Überlebensfunktion zwischen aufeinanderfolgenden Messungen bzw. Beobachtungen wird als konstant angenommen.

Ein großer Vorteil dieser KM-Kurve besteht darin, dass die Methode auch manche Arten von zensierten Daten berücksichtigen kann, besonders rechts zensierte. Häufig werden Daten nämlich links oder rechts zensiert. Wenn Geburt und Tod bekannt sind, dann ist in diesem Fall der Lebensverlauf eindeutig. Wenn man dagegen nur weiß, dass die Geburt vor einem bestimmten Zeitpunkt stattfand, dann nennt man diesen Datensatz links zensiert.

Genauso könnte nur bekannt sein, dass der Tod nach einem bestimmten Datum eintrat. Das ist dann ein rechts zensierter Datensatz. Ein Lebenslauf kann auf diese Weise auch rechts und links zensiert sein (intervallzensiert). Falls eine Person, die ein bestimmtes Alter nicht erreicht, überhaupt nicht beobachtet wird, dann ist der Datensatz abgeschnitten (engl.: truncated). Bei einem links zensierten Datensatz weiß man dagegen zumindest, dass das Individuum existierte.

Im Verlaufsdiagramm zeigen kleine Häkchen an, dass einzelne Patienten Überlebenszeiten aufweisen, die rechts-zensiert wurden. Um die Verlässlichkeit auszudrücken, ist im KM-Schätzer das Konfidenzintervall eingeführt worden. Ein Konfidenzintervall ist ein Intervall aus der Statistik, das die Präzision der Lageschätzung eines Parameters angeben soll. Das Konfidenzintervall gibt den Bereich an, der bei unendlicher Wiederholung eines Zufallsexperiments mit einer gewissen Wahrscheinlichkeit die wahre Lage des Parameters einschließt. Das Konfidenzintervall kann aus der Varianz bzw. dem Standardfehler berechnet werden.

Regressionsmodell von Cox

Die Cox-Regression ist eine nach David Cox benannte Regressionsanalyse zur Modellierung von Überlebenszeiten. Wie alle ereigniszeitanalytischen Methoden ist sie ein Verfahren zur Schätzung des Einflusses unabhängiger Variablen auf die Dauer bis zum Eintreten von Ereignissen („Überlebenszeit“) bzw. deren Hazard. Als sogenanntes semiparametrisches Verfahren liefert die Cox-Schätzung kein komplettes Vorhersagemodell für die Überlebenszeit, sondern lässt die Verteilungsfunktion der beobachteten Episodenenden unspezifiziert. Sie schätzt ausschließlich den Einfluss metrischer oder kategorialer Variablen auf einen Baseline-Hazard, von dem angenommen wird, dass er über alle Fälle hinweg konstant ist.

Die Anwendungsgebiete sind ähnlich wie in der Ereigniszeitanalyse. Das von Cox vorgeschlagene Regressionsmodell wird zur Untersuchung des Verhaltens der Ausfallraten in Abhängigkeit von Umwelteinflüssen benutzt, beispielsweise von Soldaten unter Beschuss. Grundlage des Modells sind die Einflussvektoren z von i, mit i = 1 bis n, die für jedes Individuum der Studie beobachtet werden können. Der Zusammenhang zwischen diesen Einflüssen und der Ausfallfunktion wird dann über eine festgelegte Relation h hergestellt.

H von 0 bezeichnet dabei eine unbekannte Ausfallfunktion, die im Ausgangsfall ohne Einflüsse die zugehörige Ausfallfunktion darstellt. ß ist ein unbekannter Parameter, ebenfalls n-dimensional. Aufgabe der Statistik ist die Schätzung dieses Parameters.

Da Jahrzehnte seit der Konzeption dieser beiden Methoden vergangen sind, wurden sie im Laufe der Zeit erweitert, verfeinert und modifiziert. So ist es dem Statistiker möglich, zahlreiche vom Standard abweichende Fälle zu berechnen. In jüngster Zeit kommt den Methoden der Ereignisanalyse eine besondere Bedeutung bei der Weiterentwicklung der Kausalanalyse, der Untersuchung von parallelen und interdependenten Prozessen und der Mehrebenenanalyse zu. Sicher ist aber, dass die Ereigniszeitanalyse mit bedeutenden Algorithmen arbeitet, die in keinem Statistikpaket fehlen dürfen.

:quality(80)/images.vogel.de/vogelonline/bdb/1396700/1396763/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 1

Das Problem des Handlungsreisenden und seine praktischen Anwendungen

:quality(80)/images.vogel.de/vogelonline/bdb/1404000/1404092/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 2

So verfeinert das Bayes-Theorem Spam-Filter – und mehr

:quality(80)/images.vogel.de/vogelonline/bdb/1409900/1409917/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 3

Speed für Mustererkennung mit dem Rete-Algorithmus

:quality(80)/images.vogel.de/vogelonline/bdb/1430600/1430659/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 4

Der Monte-Carlo-Algorithmus und -Simulationen

:quality(80)/images.vogel.de/vogelonline/bdb/1481900/1481934/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 5

Optimale Clusteranalyse und Segmentierung mit dem k-Means-Algorithmus

:quality(80)/images.vogel.de/vogelonline/bdb/1524900/1524972/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 7

So deckt der Local Outlier Factor Anomalien auf

(ID:45704766)

:quality(80)/p7i.vogel.de/wcms/db/d1/dbd15a5643107cf15348d4f8dca1916c/0129208933v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/9b/9f/9b9fbc0d185725638e7aa5b21535a8a0/0129324079v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/df/b0/dfb069f4822deb450a9e2901086e764a/0129063525v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4c/74/4c74fc8b159433dda8f875c353283eef/0129069237v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/69/77/6977dceebf7e9d4af0f69fc975ec7890/0129070771v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/44/17/4417973fa69edeb509aebb9aba0579b7/0128919402v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/85/2f/852ff89e3ef46f49350791602e5420ed/0128485353v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/21/00/21000a287989508668d9df02312fb708/0127948285v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e7/34/e734f4d362cad6fc347f5a049b1522db/0129238699v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/eb/93/eb93a51ff7c427f71171f547d011bfb8/0127827710v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/73/f8/73f823d4efa52d189464ba7f14e67353/0128362051v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d4/90/d49096fad857f07b788198c34b35e010/0128339234v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e1/53/e1539f6251b6e5502bd1856048c4267e/0128161589v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c9/1a/c91ad9dfc806cc7df9fe7074ca5e64dd/0127064676v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/43/e4/43e42f37cc71f12e6ae46717e700644e/0126701619v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/39/09/390978331ebdf2bcf9510be67adae57d/0126741038v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/58/df/58df8fb80642acb12018283c32bc55ad/0129070800v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/8d/62/8d62d570c33157ea78ff9697c0f8e141/0129062190v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/41/aa/41aa0e5b61dfb015100a7372018ce585/0128444593v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/a8/de/a8defd2a773ed58c7a375bb9b1765f75/0128366231v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/20/cd/20cdab2c04c467fc42fe2ffee2c14e1c/0129407259v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ba/12/ba1226ff1e87f6f485ecae3e905b1038/0128652115v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d1/4f/d14fa2b2f4a15ef443e9efc99a19c900/0129167482v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e7/6c/e76c7dca09c6ba87e568703e9226b51d/0128959729v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/a9/81/a9815e03d02e35aeb430aa22c3673bb9/0129119584v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/c1/96/c196180f8bb819e1466bb7db2ab7e728/0129295688v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/68/f8/68f8b9869e1288dfa2eeff3a1dc6a7eb/0127838110v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/74/05/74053661b14a2f12ec5e98ebd1469197/0127788138v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/0f/36/0f36632bd2160924da97db0211b6e1c0/0127421038v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/eb/bc/ebbcbb417d292f3d20cb3bf87706705c/0125514392v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/82/9a/829ab32db929fbae572a7c8290463a08/0121295821v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/48/29/4829b98ab651ba9160c517c0e1388ee2/0121130893v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/00/25/0025c1bc80460116138ea761d1209a60/0123327739v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d4/64/d464d391b4897de61d0b86ae86a5b5d7/0123914576v1.jpeg)