Grundlagen Statistik & Algorithmen, Teil 2 So verfeinert das Bayes-Theorem Spam-Filter – und mehr

Mithilfe des Satzes von Bayes lassen sich Parameter schätzen und Hypothesen induktiv testen. In einem Spamfilter können so wahrscheinliche Spam-Mails ermittelt werden. Und aus den Symptomen, die bei einem bekannten Test auftreten, lassen sich wahrscheinliche Krankheitsursachen aufspüren. Der Satz von Bayes, der bedingte Wahrscheinlichkeiten beschreibt, ist also ein nahezu universell nutzbares Werkzeug der Statistik.

Anbieter zum Thema

Treten zwei Ereignisse ein, so tun sie das unter bestimmten Bedingungen. Ob Ereignis A Ereignis B bedingt, könnte bedeuten, dass B auch A bedingt. Das könnte aber ein Trugschluss sein. Dass der Mond um die Erde kreist, bedeutet nicht, dass die Erde um den Mond kreist. Ähnliches gilt für Kausalbeziehungen. Dass 99 von 100 Mails Spam sind, lässt nicht den Schluss zu, dass auch die hundertste Mail Spam sein muss. Wird diese echte Mail so klassifiziert, handelt es sich um ein „false positive“.

:quality(80)/images.vogel.de/vogelonline/bdb/1396700/1396763/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 1

Das Problem des Handlungsreisenden und seine praktischen Anwendungen

Die Formel des Bayes-Theorems findet sich hier, gefolgt vom Beweis. Der Satz von Bayes erlaubt das Umkehren von Schlussfolgerungen: Der Nutzer geht von einem bekannten Wert P ( B ∣ A ) aus, ist aber eigentlich an dem Wert P ( A ∣ B ) interessiert (P wie Probabilität bzw. Wahrscheinlichkeit). Beispielsweise ist es von Interesse zu erfahren, wie groß die Wahrscheinlichkeit ist, dass jemand eine bestimmte Krankheit hat, wenn ein dafür entwickelter Schnelltest ein positives Ergebnis zeigt.

Aus empirischen Studien kennt man in der Regel die Wahrscheinlichkeit dafür, mit der der Test bei einer von dieser Krankheit befallenen Person zu einem positiven Ergebnis führt. Die gewünschte Umrechnung ist nur dann möglich, wenn man die Prävalenz der Krankheit kennt, das heißt, die (absolute) Wahrscheinlichkeit, mit der die betreffende Krankheit in der Gesamtpopulation auftritt.

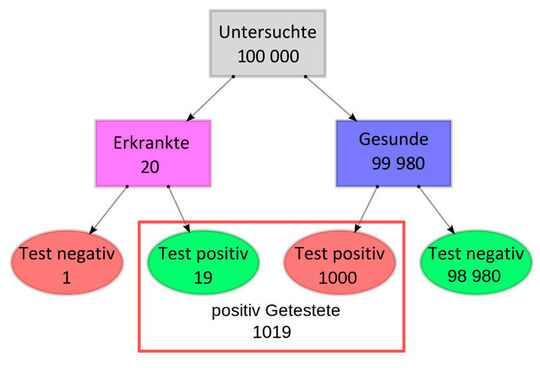

Für das Verständnis kann ein Entscheidungsbaum oder eine Vierfeldertafel helfen. Das Verfahren ist auch als „Rückwärtsinduktion“ bekannt.

Mitunter begegnet man dem Fehlschluss, direkt von P ( B ∣ A ) auf P ( A ∣ B ) schließen zu wollen, ohne die A-priori-Wahrscheinlichkeit P ( A ) zu berücksichtigen. Das kann beispielsweise passieren, wenn angenommen wird, die beiden bedingten Wahrscheinlichkeiten müssten ungefähr gleich groß sein (siehe Prävalenzfehler. Wie der Satz von Bayes zeigt, ist das aber nur dann der Fall, wenn auch P ( A ) und P ( B ) ungefähr gleich groß sind. Ebenso ist zu beachten, dass bedingte Wahrscheinlichkeiten für sich allein nicht dazu geeignet sind, eine bestimmte Kausalbeziehung nachzuweisen.

Ein Rechenbeispiel

Eine bestimmte Krankheit tritt mit einer Prävalenz von 20 pro 100.000 Personen auf. Der Sachverhalt , dass ein Mensch diese Krankheit in sich trägt, hat also die Wahrscheinlichkeit P ( K ) = 0,0002.

Die Frage lautet nun: Ist ein Screening der Gesamtbevölkerung ohne Rücksicht auf Risikofaktoren oder Symptome geeignet, Träger dieser Krankheit zu ermitteln? Es würden dabei weit überwiegend Personen aus dem Komplement KC von K getestet, also Personen, die diese Krankheit nicht in sich tragen: Die Wahrscheinlichkeit, dass eine zu testende Person nicht Träger der Krankheit ist, beträgt P ( KC ) = 1 - P ( K ) = 0,998.

T bezeichne die Tatsache, dass der Test bei einer Person „positiv“ ausgefallen ist, also die Krankheit anzeigt. Es sei bekannt, dass der Test mit 95 Prozent Wahrscheinlichkeit anzeigt (Sensitivität = P ( T│K ) = 0,95), aber manchmal auch bei Gesunden anspricht, d. h., ein falsch positives Testergebnis liefert, und zwar mit einer Wahrscheinlichkeit von P ( T│KC ) = 1 % (Spezifität = 1 - P (T│KC ) = 1 - 0,01 = 0,99).

Nicht nur für die Eingangsfrage, sondern in jedem Einzelfall insbesondere vor dem Ergebnis weiterer Untersuchungen, interessiert die „positiver prädiktiver Wert“ genannte bedingte Wahrscheinlichkeit P (K│T), dass positiv Getestete Träger der Krankheit sind. Mithilfe der Berechnung mit dem Satz von Bayes ergibt sich: Die Wahrscheinlichkeit liegt bei etwa 0,0186.

:quality(80)/images.vogel.de/vogelonline/bdb/1409900/1409917/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 3

Speed für Mustererkennung mit dem Rete-Algorithmus

Probleme mit wenigen Klassen und einfachen Verteilungen lassen sich übersichtlich im Baumdiagramm für die Aufteilung der Häufigkeiten darstellen. Geht man von den Häufigkeiten auf relative Häufigkeiten bzw. auf (bedingte) Wahrscheinlichkeiten über, wird aus dem Baumdiagramm ein Ereignisbaum, ein Sonderfall des Entscheidungsbaums. Man gelangt (natürlich) zum gleichen Ergebnis: 0,0186. (Mehr Details und Rechenbeispiele finden sich im Wikipedia-Artikel.

Anwendungsgebiete

Das Bayes-Theorem aus dem Jahr 1763 [PDF] hat einen ganzen Zweig der Statistik hervorgebracht, der auf ihm basiert: die Bayessche Statistik.

In der Statistik betrifft das Bayes-Theorem alle Fragen des Lernens aus Erfahrung, bei denen eine A-priori-Wahrscheinlichkeitseinschätzung aufgrund von Erfahrungen verändert und in eine A-posteriori-Verteilung überführt wird (vgl. den Begriff „Bayessche Statistik“. Bei letzterer wird ein Wissensstand über einen unbekannten Umweltzustand θ a posteriori, das heißt, NACH der Beobachtung einer mit θ in statistischer Abhängigkeit stehenden Zufallsgröße X beschrieben.

Im Data-Mining sind Bayes-Klassifikatoren theoretische Entscheidungsregeln mit beweisbar minimaler Fehlerrate. Allgemein bezeichnet der Begriff Klassifikator eine Instanz, die Objekte klassifiziert, d. h., in Kategorien einordnet. Sie spielen beispielsweise in Spam-Filtern eine entscheidende Rolle. Klassifikation ist eine Hauptaufgabe des Data Minings.

Es geht darum, Objekte Gruppen (hier als „Klassen“ bezeichnet) zuzuordnen. Im Gegensatz zur Clusteranalyse sind hier aber in der Regel die Klassen vordefiniert (Beispielsweise: Fahrräder, Autos) und es werden Verfahren aus dem maschinellen Lernen eingesetzt, um bisher nicht zugeordnete Objekte diesen Klassen zuzuordnen.

Bayes-Filter

In der Spam-Erkennung werden Bayes-Filter verwendet. Von charakteristischen Wörtern in einer E-Mail (Ereignis A) wird auf die Eigenschaft, Spam (Ereignis B) zu sein, geschlossen. Mit Machine Learning lässt sich der Filter verfeinern.

:quality(80)/images.vogel.de/vogelonline/bdb/1430600/1430659/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 4

Der Monte-Carlo-Algorithmus und -Simulationen

In der Disziplin der Künstlichen Intelligenz wird der Satz von Bayes verwendet, um auch in Domänen mit „unsicherem“ Wissen Schlussfolgerungen ziehen zu können. Diese sind dann nicht deduktiv und somit auch nicht immer korrekt, haben sich aber zur Hypothesenbildung und zum Lernen in solchen Systemen als durchaus nützlich erwiesen.

Im Qualitätsmanagement wird das Bayes-Theorem zur Beurteilung der Aussagekraft von Testreihen genutzt, ähnlich wie in der Medizin (s. o.). In der Entscheidungstheorie bzw. Informationsökonomik ziehen Experten den Satz von Bayes zur Bestimmung des erwarteten Wertes von zusätzlichen Informationen heran. Das soll den nötigen Beschaffungsaufwand begrenzen bzw. steuern.

Natürlich gibt es noch zahlreiche weitere Verwendungsmöglichkeiten für das Bayes-Theorem, doch sie reichen weit über die Informationstechnologie im engeren Sinne hinaus, beispielsweise in die Verkehrssteuerung. Aber es wird deutlich, wie vielseitig verwendbar ein aus dem Jahr 1763 stammender Satz und seine zahlreichen Ergänzungen sein kann.

:quality(80)/images.vogel.de/vogelonline/bdb/1481900/1481934/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 5

Optimale Clusteranalyse und Segmentierung mit dem k-Means-Algorithmus

:quality(80)/images.vogel.de/vogelonline/bdb/1509200/1509209/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 6

Die Ereigniszeitanalyse – wenn Anfang und Ende die Erfolgsrate bestimmen

:quality(80)/images.vogel.de/vogelonline/bdb/1524900/1524972/original.jpg)

Grundlagen Statistik & Algorithmen, Teil 7

So deckt der Local Outlier Factor Anomalien auf

(ID:45332347)

:quality(80)/p7i.vogel.de/wcms/df/b0/dfb069f4822deb450a9e2901086e764a/0129063525v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4c/74/4c74fc8b159433dda8f875c353283eef/0129069237v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/0d/7d/0d7d4d387b2df6692d3d0f729d4680d9/0128775027v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ab/71/ab71eadf052742a3133b1bf01a5b4094/0128381066v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/69/77/6977dceebf7e9d4af0f69fc975ec7890/0129070771v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/44/17/4417973fa69edeb509aebb9aba0579b7/0128919402v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/85/2f/852ff89e3ef46f49350791602e5420ed/0128485353v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/21/00/21000a287989508668d9df02312fb708/0127948285v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/eb/93/eb93a51ff7c427f71171f547d011bfb8/0127827710v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/73/f8/73f823d4efa52d189464ba7f14e67353/0128362051v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d4/90/d49096fad857f07b788198c34b35e010/0128339234v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/95/a9/95a926949a211ff3f81e7e99876c5065/0128215860v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e1/53/e1539f6251b6e5502bd1856048c4267e/0128161589v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c9/1a/c91ad9dfc806cc7df9fe7074ca5e64dd/0127064676v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/43/e4/43e42f37cc71f12e6ae46717e700644e/0126701619v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/39/09/390978331ebdf2bcf9510be67adae57d/0126741038v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/58/df/58df8fb80642acb12018283c32bc55ad/0129070800v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/8d/62/8d62d570c33157ea78ff9697c0f8e141/0129062190v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/41/aa/41aa0e5b61dfb015100a7372018ce585/0128444593v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/a8/de/a8defd2a773ed58c7a375bb9b1765f75/0128366231v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e7/6c/e76c7dca09c6ba87e568703e9226b51d/0128959729v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/78/43/7843aa74049df153fbe3a48504b78e13/0128881472v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ed/03/ed03b3f1a51ed083929721c823be9a72/0128967846v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/4b/b4/4bb4a38dd71121f624a7a465dabcf4cc/0128735549v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/7b/88/7b88c3b2a1abe09513fb25943b91f852/0129106836v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/9f/ba/9fba1120e021f71cd7609844067b8cf8/0129116615v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/68/f8/68f8b9869e1288dfa2eeff3a1dc6a7eb/0127838110v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/74/05/74053661b14a2f12ec5e98ebd1469197/0127788138v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/0f/36/0f36632bd2160924da97db0211b6e1c0/0127421038v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/eb/bc/ebbcbb417d292f3d20cb3bf87706705c/0125514392v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/82/9a/829ab32db929fbae572a7c8290463a08/0121295821v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/48/29/4829b98ab651ba9160c517c0e1388ee2/0121130893v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/00/25/0025c1bc80460116138ea761d1209a60/0123327739v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/12/04/12041637d9baac345d47e80f079c259c/0128030446v2.jpeg)